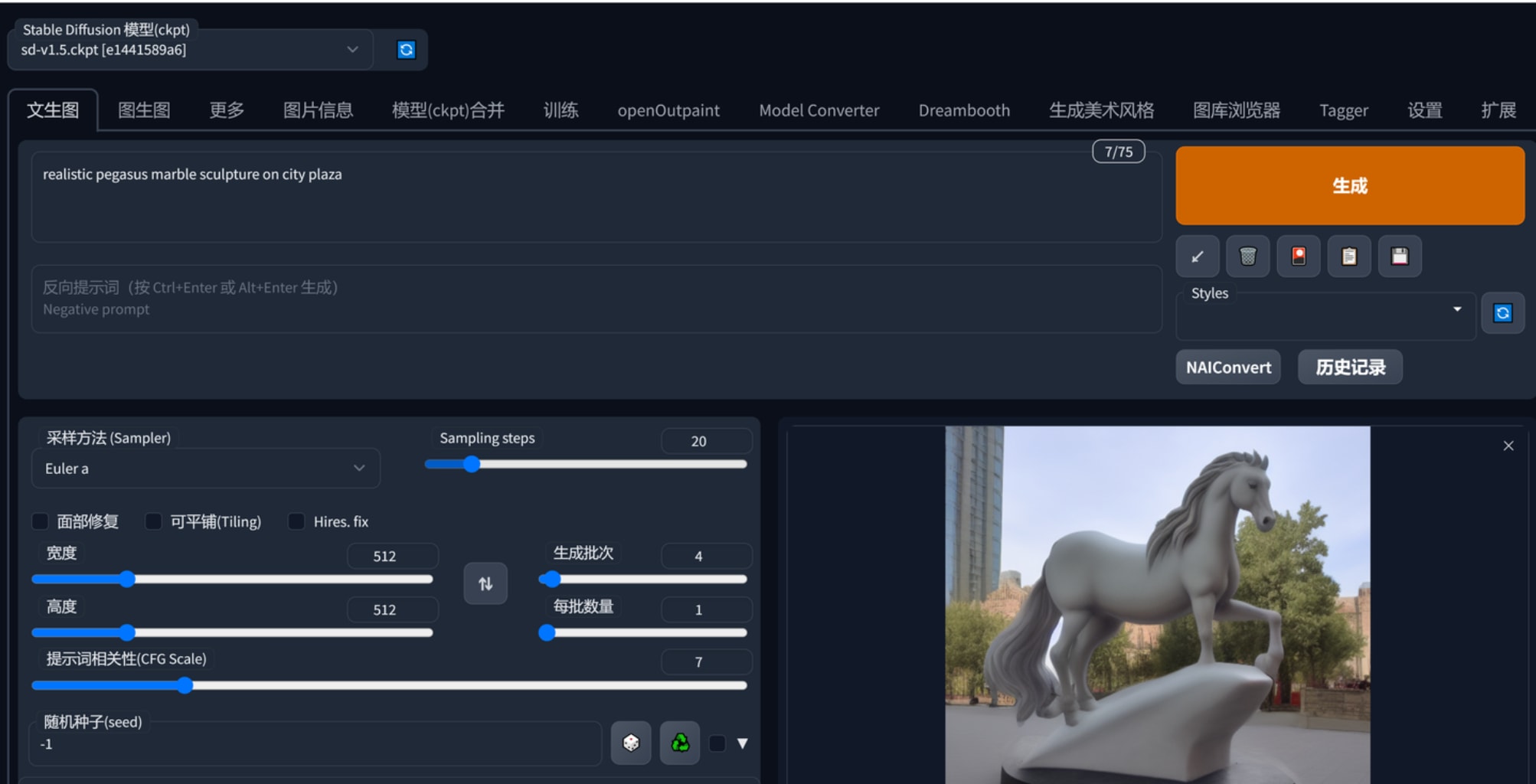

测试了stable diffusion liblib在线生图,可以用浮雕相关的lora转换图片为浮雕,liblib每天免费300次图片生产,对于浮雕制作是够用了,于是我想把d盘空间释放出来,sd就用不着了,本地版不知道为何可能是大模型不对?总之就是一样的设置做出来的图效果很不好。浮雕用aiuni生产glb模型效果很不好,因此这一块就用liblib生产png,然后zbrush drag替换alpha。

测试了stable diffusion liblib在线生图,可以用浮雕相关的lora转换图片为浮雕,liblib每天免费300次图片生产,对于浮雕制作是够用了,于是我想把d盘空间释放出来,sd就用不着了,本地版不知道为何可能是大模型不对?总之就是一样的设置做出来的图效果很不好。浮雕用aiuni生产glb模型效果很不好,因此这一块就用liblib生产png,然后zbrush drag替换alpha。

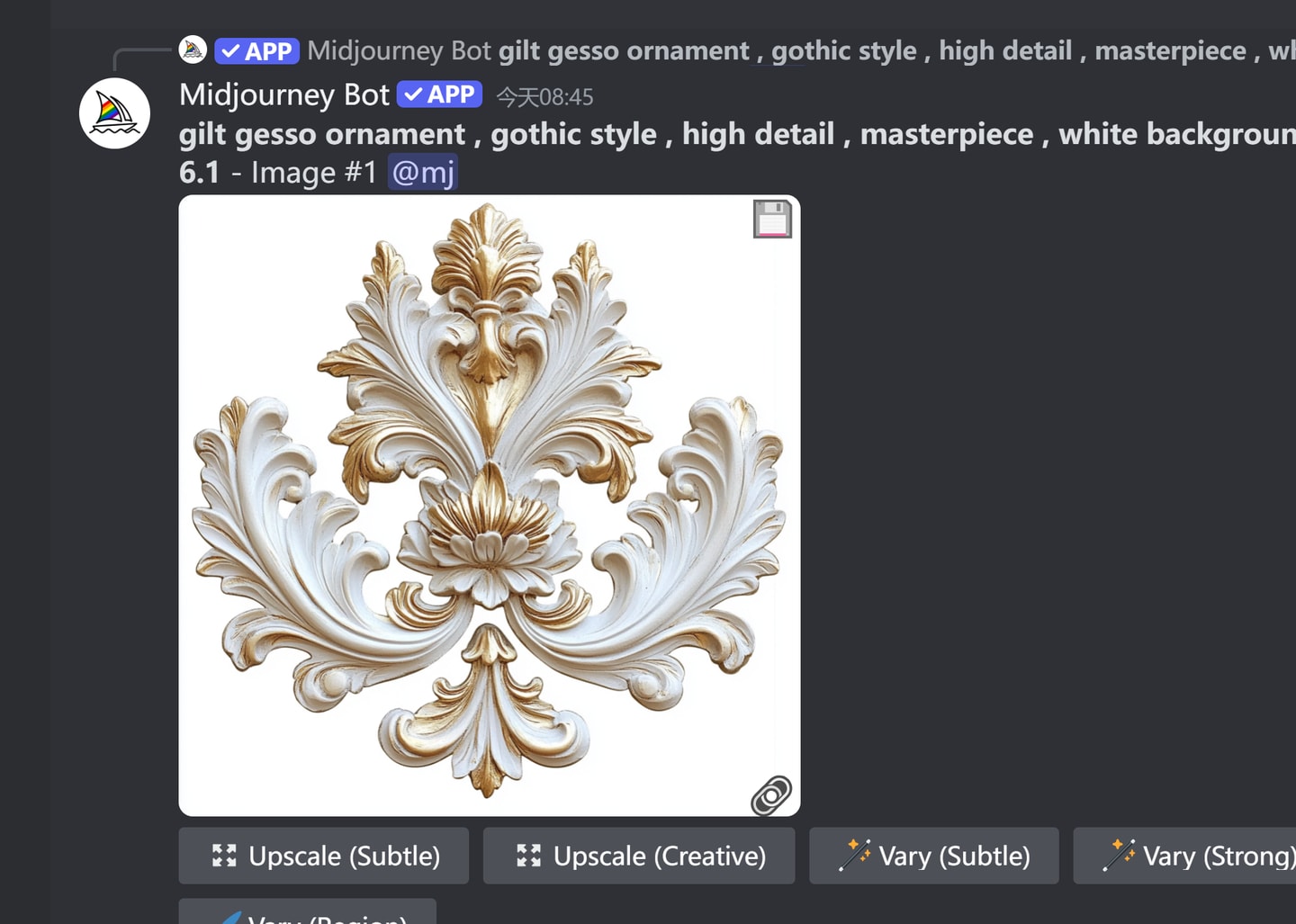

stable diffusion我看了下文件夹的日期信息,我是在去年10月份下载的,midjourney等一众ai作图软件也是那个时间开始接触的。那个时候我只知道midjourney可以根据关键词生成图,可以根据参考图生成图,可以对选定的图生成类似创意图,stable diffusion可以根据关键词生成图。 stable diffusion有繁杂的设置,我都没去碰。

Update your browser to view this website correctly. Update my browser now